Inhaltsverzeichnis

Quantitative Analysis of Culture using Millions of digitized Books

Jean-Baptiste Michel*, Yuan Kui Shen, Aviva Presser Aiden, Adrian Veres, Matthew K. Gray, The Google Books Team, Joseph P. Pickett, Dale Hoiberg, Dan Clancy, Peter Norvig, Jon Orwant, Steven Pinker, Martin A. Nowak, and Erez Lieberman Aiden*. Quantitative Analysis of Culture Using Millions of Digitized Books. Science (Published online ahead of print: 12/16/2010).

1. Forschungsziel

Das Forschungsprojekt „CULTUROMICS“ hat zum Ziel kulturelle und linguistische Trends zwischen den Jahren 1800 und 2000 quantitativ darzustellen. Dies soll anhand der Analyse von digitalisierten Büchern bewerkstelligt werden. Hierfür werden lediglich die einzelnen Wörter betrachtet.

2. Datenauswahl

Anhand der Qualität der OCR (Optical Character Recognition) und der Metadaten wurden 5 Mio. Bücher ausgewählt. Diese umfassen 4% aller Bücher, die jemals gedruckt wurden (5.195.769 Bücher – 500 Mrd. Wörter). Bisher gab es bei quantitativen Kulturforschungen meist keine adäquaten Daten.

Quellen: Google books, Wikipedia, Encyclopedia Britannica, American Heritage Dictionary

Sprachen: Englisch, Französisch, Spanisch, Deutsch, Chinesisch, Russisch, Hebräisch

3. Methodik

GoogleBooks als Quelle

2004 begann Google damit, Bücher zu scannen und zu digitalisieren, um diese online verfügbar zu machen. Seitdem wurden mehr als 12% (~ 15 Mio.) aller jemals veröffentlichten Bücher erfasst. Der Datensatz beinhaltet Bücher, die seit dem Jahr 1473 veröffentlicht wurden. Er umfasst 4,5 Mrd. Seiten in 478 unterschiedliche Sprachen.

Die Bücher wurden Google zum Teil von den Herausgebern zur Verfügung gestellt oder aber aus großen Bibliotheken entliehen. Nicht nur das Buch wurde digitalisiert, sondern auch die dazugehörigen Metadaten. Diese bestehen aus den Informationen zu Autor, Jahr der Veröffentlichung, den Informationen zur Edition, Sprache, Herausgeber, Buchdeckel, Fuß- und Kopfzeilen und den Seitenzahlen.

Google teilte die Metadaten in Gruppen ein. Hierbei wurden die Metadaten, welche das gleiche Buch beschreiben (bspw. Tom Sawyer), Bücher, die mehrere Teile haben und alle Bücher einer Ausgabe in einer Aufzeichnung zusammengefasst. Die Bücher wurden durch Scanverfahren digitalisiert und anhand von OCR erfasst. Durch OCR wurden auch die Metadaten überprüft (vgl. Michel et. al. 2010: 3-5).

Culturomics

Die Auswahl der Daten aus dem Googledatensatz erfolgte anhand der Qualität der Metadaten (z.B. Erscheinungsjahr) und der OCR Qualität. Hierfür wurde ein Algorithmus erstellt, der berechnet, wie wahrscheinlich es ist, dass die Daten korrekt sind. Hierfür wurden der Abstand, die Höhe, die Wahrscheinlichkeit von 2 Buchstaben nebeneinander und die unterschiedlichen Angaben zu Sprache und Zeit (1550-2008) überprüft (vgl. ebd. 6-8).

- Aufteilung des Datenkorpus nach…

- Sprache –> anhand der Metadaten und des Spracherkennungsalgorithmus „Popat“

- Thema/Kategorien–> anhand des BISAC-Siegels (Book Industry Standards and Communication)

- Publikationsland –> anhand der Metadaten

(vgl. ebd. 9)

- Vorgehen

Tokenisierung:

Der gesamte digitalisierte Text wurde in 1-grams aufgeteilt. Anschließend wurden die n-grams gebildet. Ein n-gram ist ein für sich stehender Begriff, welcher aus mehreren zusammengesetzten Einzelwörtern besteht, wie zum Beispiel „United States of America“. „n“ entspricht maximal 5 Wörtern und das jeweilige n-gram muss mindestens 40mal innerhalb eines Jahres vorkommen. Ein n-gram ist verbreitet, wenn es öfter als 1 mal pro Mrd. vorkommt (bei 90% der Wörter lag der Koeffizient über 10^-9 und bei 70% über 10^-8).

Anschließend wurde anhand einer Stichprobe von Büchern nochmal untersucht, wie oft alle Wörter vorkommen, auf wie vielen Seiten und in wie vielen Büchern.

Rechnung: Die Nutzungshäufigkeit eines Wortes wird bemessen, indem man die Anzahl dieses Wortes innerhalb eines bestimmten Jahres durch die Anzahl aller in diesem Jahr vorkommenden Wörter teilt. Es wird also gezählt, wie häufig das Wort im Vergleich zu anderen Wörtern vorkommt. Dies dient zur Relativierung der Datengröße des jeweiligen Jahres (vgl. ebd. 10-15).

4. Analyse

(vgl. Michel et. al. 2011: 177-182)

Quellen historischer und kultureller Daten

Für die Analyse wurden Daten über kulturelle und historische Gegebenheiten aus Wikipedia genutzt, da diese Daten öffentlich zugänglich und ohne Einfluss der Studie entstanden sind. Händische/persönliche Anmerkungen wurden so gut es ging vermieden, um die Studie nicht zu beeinflussen (Beispiele für Daten aus Wikipedia: Präsidenten und Monarchen, Verträge, Namensänderungen von geographischen Gebieten). Weitere Quellen waren die Encyclopedia Britannica und das American Heritage Dictionary.

Ergebnisse

Es wurden Ergebnisse für die Bereiche der Lexikographie, der Grammatikevolution, über kollektives Gedächtnis, der Technologieadaption, des Strebens nach Ruhm, der Zensur und der historischen Epidemiologie veröffentlicht.

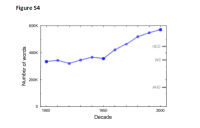

The size of the English lexicon

Im American Heritage Dictionary werden 153.459 Wörter aufgeführt. Dazu gehören auch Wörter, die z.B. aus 2 Wörtern bestehen (men’s room) oder die öfter auftauchen, weil sie unterschiedliche Bedeutungen haben. Nach Ausschluss dieser Worte, kommt man auf insgesamt 116.156 einzigartige 1-grams.

Um auch Namen und Firmennamen ausschließen zu können, sollten Native speaker Samples von 1000 Wörtern der Jahre 1900, 1950 und 2000 in verschiedene Kategorien einordnen.

Die Analyse der Anzahl der Worte, die tatsächlich in Büchern verwendet werden ergab, dass ungefähr 8.500 Wörter pro Jahr zum Wortschatz hinzu kommen. Der Wortschatz wird also immer größer. In den letzten 50 Jahren hat er sich etwa verdoppelt.

ABER: Im Wörterbuch sind nicht alle Wörter vermerkt! Auch zu beachten ist, dass veraltete Worte aus dem Wörterbuch entfernt werden müssen bzw. nicht versehentlich hinzugefügt werden.

The evolution of grammar

Innerhalb dieses Forschungskapitels wurde die Entwicklung von regelmäßigen und unregelmäßigen Verben untersucht. Zuerst wurden mehrdeutige Wörter (z.B. dive/dove ; bet/bet) und zusammengesetzte Verben (z.B. overpay), die meist der Grundform entsprechen, ausgeschlossen. Die 106 übrigen Verben wurden untersucht, indem die regelmäßigen und die unregelmäßigen Formen jeweils verglichen wurden.

Die Auswertung ergab, dass sich die Verwendung von Verbformen über die Zeit verändert. Daraus lassen sich Rückschlüsse auf den Sprachgebrauch der Bevölkerung ziehen. Zum Beispiel hat sich die Verwendung von sneaked von 100% auf 50% in den letzten 50 Jahren vermindert, während sich die Verwendung von snuck auf 50% erhöht hat. Daraus schlussfolgerten die Forscher*innen, dass etwa 3 Mio. Menschen pro Jahr ihre Sprechweise ändern.

Kollektives Gedächtnis

Die Ergebnisse dieses Kapitels lagen darin, dass der Höhepunkt der Häufigkeitskurve einer Jahreszahl immer erst nach einigen Jahren auftritt. Dies liegt daran, dass beispielsweise Bücher, die über das Jahr 1950 geschrieben wurden, erst nach dem Jahr 1950 geschrieben und veröffentlicht wurden. Nach dem Höhepunkt folgt ein exponentieller Verfall der Anzahl der Erwähnungen des Jahres.

Eine weitere Erkenntnis lag darin, dass es etwa drei Jahre dauert, bis sich eine geographische Namensänderung durchsetzt und häufiger benutzt wird.

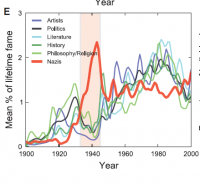

Ruhm

Um die Berühmtheit von Personen zu analysieren, wurde auf zwei Quellen zurückgegriffen: Wikipedia und die Encyclopaedia Britannica.

Da die Daten aus Wikipedia sehr umfangreich sind, wurden diese Listen gefiltert. Manche Menschen sind unter einem Pseudonym oder unter verschiedenen Namen bekannt und es kommt auch vor ,dass zwei bekannte Persönlichkeiten den gleichen Namen tragen. Deshalb wurde für die Analyse nur die berühmteste Person oder der berühmteste Name einer Person berücksichtigt. Alle Schreibweisen dieses Namens wurden eingeschlossen (Bsp.: Nummer am Ende: auch ohne Nummer; Apostroph: auch ohne…). Das Geburtsjahr der Personen wurde auf die Zeitspanne zwischen 1800 und 1980 eingeschränkt. So konnten fiktive Personen ausgeschlossen werden. Die Liste enthielt Informationen bezüglich Biographie, Geburtsjahr, heutige Berühmtheit (gemessen an der Häufigkeit der Wikipediaaufrufe im März 2010) und die Kategorie der Berühmtheit. Die 50 berühmtesten Menschen der jeweiligen Kategorie wurden ausgesucht. Folgende Fragen wurden untersucht: Wann wurden sie berühmt?, Wann waren sie am berühmtesten?, Wie entwickelte sich ihre Berühmtheit?

Die Analyse ergab, dass die Personen heutzutage früher berühmt werden (43 auf 29 Jahre) und durchschnittlich mit 75 Jahren am berühmtesten sind. Allerdings sind sie viel schneller am Höhepunkt ihrer Berühmtheit angelangt (von 8,1 auf 3,3 Jahre) und werden schneller vergessen (Halbwertszeit nach 120/71 Jahren).

Beim Britannica Dataset kamen die Forscher*innen zu ähnlichen Ergebnissen.

Bei der Interpretation ist auch zu beachten, dass Menschen mehr hinterlassen als nur ihren Namen (Bspw. Merry Shelly ist vergessen, Frankenstein dagegen nicht).

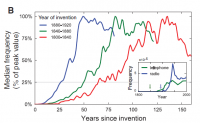

Zunächst wurde eine Liste aller Erfindungen aus den Jahren 1800 bis 1960 aus Wikipedia entnommen. Diese wurde auf Doppeldeutigkeiten geprüft. Der jeweils gängigste Name für eine Erfindung wurde ausgewählt. Wenn es keinen eindeutigen Namen gab, wurde die Erfindung nicht beachtet.

Die Forscher*innen fanden heraus, dass Erfindungen sich in der heutigen Zeit schneller verbreiten. Zu beachten ist, dass es auch vorkommen kann, dass Erfindungen schnell berühmt wurden und mittlerweile schon wieder vergessen sind und daher nicht in Wikipedia auftauchen. Diese Problematik tritt besonders bei sehr alten Erfindungen auf. Allerdings ist es aufwändig Listen zu erstellen, die auch diese Gruppe von Erfindungen berücksichtigen. Außerdem würde die Erstellung dieser Liste die Transparenz der Studie beeinflussen.

Um die Auswirkungen von Zensur zu untersuchen, wurde die schwarze Liste von Wolfgang Herrmann als Kernpunkt der Untersuchung betrachtet. Die Wikipedia Version der Liste wurde händisch von einer unabhängigen Person geprüft und abgeglichen. Ebenso wurde die Liste, die von der Stadt Berlin digitalisiert wurde, zum Vergleich hinzugezogen (Namen wurden vervollständigt). Auch Hitler selbst steht auf der schwarzen Liste wegen eines Kommentars seinerseits in einem französischen Buch. Die Forscher*innen wollten seinen Namen jedoch nicht entfernen, da sie nicht selbst urteilen und die Daten beeinflussen wollten (Hitler als Ausreißer). Die Liste mit Nazimitgliedern wurde aus verschiedenen Wikipediakategorien gewonnen (Suchbegriffe: Nazi_leader, SS_officers,…). Von insgesamt 56.500 Menschen wurden die 500 Berühmtesten jedes Jahres herausgesucht, die zwischen 1800 und 1913 geboren wurden. Nun wurde ein Vergleich zwischen dem deutschen und dem englischen Datensatz angestellt. Die Ergebnisse wurden qualitativ überprüft. Ein Mensch mit einem Abschluss in deutscher und jüdischer Literatur sollte 100 unterdrückte und 100 profitierende Personen zuordnen und kommentieren. Sie kam zu relativ ähnlichen Ergebnissen.

Epidemien

Um historische medizinische Daten zu verbessern, wurden verschiedene Epidemien (Influenza, HIV, Cholera und Poliomyelitis) untersucht. Das Vorgehen ähnelt dem Prinzip der Häufigkeit von Googlesuchanfragen zu einer bestimmten Zeit.

Die Ergebnisse passen zu den bekannten Epidemien mit einer Ausnahme: Polio. Es gab eine Epidemie in den 51-55er Jahren, diese stach jedoch anhand der Daten nicht heraus, da das Thema schon in den 30ern bis zum Ende der 60er Jahre von gesteigertem Interesse war. Dies könnte mit der Wahl von Franklin D. Roosevelt 1932, der Impfung 1952 und der oralen Impfversion von 1962 zusammenhängen.

5. Reflexion

Mögliche Fehlerquellen

- Datengröße: Nur die Bücher ab 1800 wurden verwendet, da in den Jahren zuvor zu wenige ngrams pro Jahr vorhanden waren und somit nicht in Zusammenhang mit den anderen Daten gesetzt werden konnten.

- Qualität der Metadaten: Bsp. Eine Metadatenquelle gab bei Unsicherheit 1899 als Erscheinungsjahr an. Es wurde versucht, Fehler wie diese systematisch zu vermeiden.

- Kontext: In der Studie werden nur einzelne Begriffe betrachtet und nicht der Zusammenhang, in welchem sie genannt werden. Dadurch kann bei der Analyse eine Verzerrung entstehen. Der Entstehungskontext der Bücher wird ebenfalls nicht in die Analyse miteinbezogen. So werden manche Bücher zum Beispiel von politischen Akteur*innen in Auftrag gegeben, spiegeln aber nicht die reale gesellschaftliche Lage wider.

Probleme

- Zusammensetzung der Daten: Die meisten der 4% aller Bücher stammen aus Bibliotheken. Sie spiegeln daher die Bestände der Bibliotheken wider. Der Digitalisierungsprozess von GoogleBooks begann 2004. Seit diesem Zeitpunkt wurden viele Bücher von Verlagen an Google geschickt und die Zusammensetzung der Daten hat sich dadurch verändert. Da die Auswirkungen auf den Datensatz nicht erfasst werden können, wurden nur Bücher bis einschließlich des Erscheinungsjahres 2000 analysiert.

- Die Studie greift lediglich auf Bücher zurück, nicht auf Journals, Zeitungen etc. Dadurch ist die Aktualität und die Aussagekraft der Daten begrenzt.

- Bei der Betrachtung der Häufigkeitsschaubilder gibt es verschiedene Problematiken. Die Suchfunktion hat keine Fachgebietseinstellung. Außerdem werden Wörter nur in der Verfassungssprache angezeigt und doppeldeutige Wörter können nicht voneinander unterschieden werden. Ein Wort kann in mehreren Fachgebieten verwendet werden und kann nicht eindeutig einem Zusammenhang zugeordnet werden. Wörter innerhalb eines Themenbereiches können sich über die Jahre verändern d.h. es kann vorkommen, dass das Interesse zu einem Phänomen gleich geblieben ist, sich jedoch das Wort verändert hat, mit welchem man dieses Phänomen bezeichnet. All diese Probleme können nicht als Verzerrungsfaktor der Ergebnisse ausgeschlossen werden (vgl. Michel et al., 2011: 176)

- Die Forscher*innen haben bereits historische Vorkenntnisse. Somit kann eine vollkommene Unvoreingenommenheit gegenüber den Daten nicht gewährleistet werden.

- Es liegen keine Daten zur Relevanz oder zur Beliebtheit der Bücher vor.

Kritik zu GoogleBooks

- Hegemonie des Englischen (USA). Kleinere Sprachen werden wenig bis gar nicht beachtet (Eurozentrismus)

- Mangelhafte Metadaten durch techn. Mängel (OCR)

- Copyright-Probleme mit Autoren und Verlägen

- GoogleBooks ist im Besitz fast aller digitalisierten Bücher und hat somit eine Machtposition inne.

- Google hat die Entscheidungsmacht darüber, welche Bücher in den ngram Viewer aufgenommen werden und welche nicht digitalisiert werden sollen.

Möglichkeiten

- Bessere Datenqualität

- Interdiszplinarität der Forschung und der Ergebnisse (Veröffentlichung des Projektes im „Science“ um keine Wissenschaft zu bevorzugen.)

- Die Studie ist darauf ausgelegt diese weiterzuführen bzw. zu erweitern. Zum Beispiel anhand weiterer Analysen oder indem beispielsweise eine kleinere Sprache in den Datensatz aufgenommen wird (Sprachenerweiterung).

- Methodenmix (händische Überprüfungen innerhab des methodisch festgelegten Vorgangs)

Limits

- Zeit: Es kann nur die Vergangenheit betrachtet werden.

- Bücher beziehen sich nicht immer auf die Zeit ihrer Veröffentlichung. Sie können beispielsweise Themen betrachten, welche in der Vergangenheit liegen. Außerdem entspricht der Zeitpunkt der Entstehung des Buches nicht dem Veröfentlichungsdatum.

- Wie aktuell und relevant sind die Daten? (1800-2000)

- Es ist mit dieser Methode nur möglich das verschriftlichte Wort zu betrachten und nicht das gesprochene (Umgangssprache). Dadurch ergibt sich auch die Problematik, dass zum Beispiel mündliche Überlieferungen nicht im Datensatz aufgenommen wurden. Diese sind in manchen Kulturkreisen besonders wichtig.

- Repräsentativität: Welche Gesellschaftsschicht wird ausgeschlossen? Die Bücher werden von einem begrenzten Kreis von Personen gelesen und man kann auch keine Rückschlüsse daraus ziehen, ob beispielsweise die enthaltene Meinung eines Buches geteilt wurde/wird oder nicht.

- Autor*innen: Die Bücher werden nur von einem*r oder wenigen Autor*innen verfasst. Sie spiegeln also die Schilderung eines Sachverhaltes dieser einen Person wider und nicht die der gesamten Bevölkerung. Es liegt also nur eine eingeschränkte Repräsentativität der Bücher vor.

6. Diskussionspunkte

Inwiefern könnte man diese Vorgehensweise auf soziologisch relevante Themenfelder anwenden, bzw. ist dies überhaupt möglich?

Was müsste man beachten?

Worin liegt der (soziologische) Sinn der Studie?

Ist das Messinstrument adäquat zum Gegenstand?

(Beispielsweise wurde in der Studie zum Phänomen „Ruhm“ geforscht, jedoch wurde das Phänomen vorher nicht genau definiert.)

7. Fazit

Die Methodik der Studie eignet sich unserer Meinung nach besonders für linguistische Untersuchungen. Für die Auswertung von historischen und gesellschaftlichen Ereignissen ist die Methodik nur bedingt geeignet, da der Datensatz der Bücher viele Probleme in sich birgt. Die Auswertung der Daten erschwert sich durch den fehlenden Kontext der Wörter. Dieser wird durch die Verwendung von historischen Daten bei der Analyse wieder auf die Daten projiziert. Hierdurch wird deutlich, dass der Prozess viele unreflektierte Gefahrenquellen beinhaltet .

Es sollte jedoch auch hervorgehoben werden, dass das methodische Vorgehen der Studie eine Vielfalt an traditionellen Methoden mit neuen Ansätzen mischt und verbindet. So werden zum Beispiel viele Arbeitsschritte durch eine händische Überprüfung von Stichproben kontrolliert. Durch die kontinuierliche Reflexion der einzelnen Analyseschritte wurden viele potentielle Fehler vermieden. Auf Grundlage dieser Studie können weitere Verfahren entwickelt werden.

Inwiefern die Datengrundlage, das Vorgehen und die Analysemethoden der Studie für soziologische Forschungsfragen sinnvoll ist, bleibt offen.

8. Quellen und Links

Michel, J.-B/Shen, Y. K./Aiden, A. P./Veres, A./Gray, M. K./Pickett, J. P. 2011. Quantitative Analysis of Culture Using Millions of Digitized Books: 176-182.

Michel, J.-B./Shen, Y. K./Aiden, A. P./Veres, A./Gray, M. K./Pickett, J. P. 2010. Supporting Online Material for: Quantitative Analysis of Culture Using Millions of Digitized Books Materials and Methods.

Zur Website der Studie: http://www.culturomics.org/

Google Ngram Viewer: https://books.google.com/ngrams