Inhaltsverzeichnis

Einführung

Im Folgenden werden zwei Studien vorgestellt, die mit Twitterdaten geforscht haben. In der Darstellung der ersten Studie von Lewis, Zamith und Hermida liegt der Fokus auf der methodischen Verfahrensweise. Die Ergebnisse der Studie sind dabei nicht relevant und bleiben unbeachtet. In der zweiten Studie von Thimm, Einspänner und Dang-Anh liegt der Schwerpunkt hingegen auf der Vorgehensweise bei der Analyse. Außerdem werden die Ergebnisse kurz dargestellt.

Studie 1: Auswahlfokus

Einleitung

Neue Technologien ermöglichen einen einfacheren Umgang mit Big Data für die Sozialwissenschaften. Durch die sozialen Medien können Forscher*innen schneller an größere Datensätze herankommen, wodurch neue Perspektiven, Möglichkeiten und Forschungsfelder eröffnet werden. Neue computergestützte Analysemethoden der medialen Inhaltsanalyse können nun angewendet werden, da das sammeln, auswerten und interpretieren von einem bestimmten Thema anhand eines sozialen Mediums, wie Twitter, nun einfacher erfolgen kann. Dabei ist festzustellen, dass die traditionelle Methode der Inhaltsanalyse nicht ausreichend ist, um das Internet und seine Inhalte zu bewältigen. Dafür sei die traditionelle Inhaltsanalyse nicht konzipiert worden. (Lewis et all. 2013: 35) Im Gegensatz dazu sei aber die computergestützte Methode mit der algorithmische Analyse von Inhalten nicht oder nur beschränkt in der Lage Feinheiten und latente Bedeutungen der Sprache zu verstehen. (vgl. ebd.) Somit stellt sich die Frage, wie Wissenschaftler*innen die systematische Starre und kontextuellen Kenntnisse der traditionellen Inhaltsanalyse am wirksamsten einsetzen, während die Vorteile aus der Effektivität der computergestützten Methode und dem neuen Forschungsbereichen des Big Data Phänomens geschöpft werden können. Die Autoren sind der Meinung, dass durch eine Verschmelzung der manuellen und computergestützten Ansätze fruchtbare Ergebnisse zustande kommen können. Der Ansatz könne die Stärke der traditionellen Inhaltsanalyse beibehalten, während sie durch Algorithmen die Genauigkeit, Effizienz und Kapazität maximiere. (Vgl. ebd: 36) Durch die im Artikel vermittelte Studie sollen auch neue Erkenntnisse über die Veränderung der journalistischen Informationsbeschaffung im Vernetzungszeitalter gewonnen werden. Dieser Prozess war und ist weiterhin kaum für die Öffentlichkeit einsehbar, falls keine öffentliche Interaktion zwischen Reporter*innen und ihrer Quellen auf Twitter entsteht. Die sozialen Medien machen also den Sourcing-Prozess sichtbar. Dadurch entstehen neue Forschungsansätze für Forscher*innen, um die Dynamiken der Machtverhältnisse und Einflüsse bei der Nachrichtenproduktion aufzudecken.

Inhaltsanalyse in Zeiten der Big Data

Durch die Etablierung des Internets entstehen neue zahlreiche Herausforderungen bezüglich der traditionellen Konzeptualisierung der Inhaltsanalyse. Nach einer Feststellung der Forscher*innen McMillan, Weare und Linn ist die Repräsentativität aufgrund der Weitläufigkeit des Internets kaum möglich; es herrschen Schwierigkeiten bei der Definition der Einheiten und die Reliabilität, welche durch die Codierung entsteht, sei ebenfalls problematisch. (vgl. ebd.) Sie folgern, dass kleinere Anpassungen traditioneller Ansätze der Inhaltsanalyse, wie etwa der Gebrauch von Software um Snapshots von Internetseiten zu erstellen, notwendig seien, um den Herausforderungen entgegen zu stehen. Die sozialen Medien beinhalten zum einen eigene Strukturmerkmale und zum anderen einen soziokulturellen Kontext. Die Inhaltsanalyse der Twitternutzung von Journalist*innen, Nachrichtenagenturen, Auslandskorrespondent*innen und NGO’s würde anhand beispielsweise von Retweets und der Reply-Funktion analysiert werden. Dabei ist es durch eine reine manuelle Inhaltsanalyse schwierig die wichtigsten Daten innerhalb der Masse aufzufangen. Viele wichtige Daten würden nicht archiviert und somit nicht in die Forschung einbezogen.

Computergeschützte Methoden als Lösung

An dieser Stelle können computergestützte Methoden zur Hilfe verwendet werden. Big Data brachte viele digitale Verbesserung in die sozialwissenschaftliche Forschung, wie etwa Tools, Softwares und Techniken um mit den Daten zu arbeiten. Es ist nun möglich anhand einer Menge von Daten und durch Softwares oder Programme menschliches Verhalten zu sortieren und zu analysieren. Jedoch wirft dies die Frage nach der Ethik, der Epistemologie, dem Verbraucherdatenschutz und der Forschungethik auf. Die Herausforderung durch Massendaten der manuellen Inhaltsanalyse wurde in den vergangenen Jahren durch zwei Taktiken gelöst: Entweder wurden Daten aus dem Sampling willkürlich ausgeschieden oder mehr Codierer*innen wurden eingesetzt, um die Masse zu bewältigen. Computergeschützte Inhaltsanalyse könne diese Herausforderungen umgehen, indem sie zum einen Algorithmen systematisch erfasst und bei Interesse den Korpus für die spezialisierte Analyse verkleinert und zum anderen durch textanalytische und concept-mapping tools Stichwörter heraussuchen und diese in ihrer Nutzung analysiert.

Durch die Verschmelzung beider Methoden, also einem hybriden Ansatz, können sowohl Strukturmerkmale, als auch der soziokultureller Kontext analysiert werden. (siehe Forschung über die Nachrichtenproduktion eines norwegischen Broadcasters, S. 38f.)

Fallstudie und Ergebnisse

Andy Carvin ist ein social-media Stratege der NPR und nutzte Twitter als virtuelle Nachrichtenzentrale während des arabischen Frühlings. Analysiert wurde, wen er retweetete und wie er bestimmte Personen zitiert.

Twitter als Nachrichtenzentrale und Nachrichtenagentur

Twitter wurde in der Studie als eine Nachrichtenagentur aufgefasst, da eine kontinuierliche Aktualisierung von öffentlichen Quellen in Form von rohem Material in Echtzeit geliefert wurde. Außerdem wurde Twitter als Nachrichtenredaktion bezeichnet, da ein gemeinschaftlicher öffentlicher Raum für Informationsverarbeitung entstand. Berichte wurden ausgewertet, Fakten verifiziert und relevante Informationen hervorgehoben. Dabei geschieht die Selektion der relevanten Inhalte nicht durch eine Person, die in einem geschlossen Raum sitzt, sondern durch die Nutzer*innen des sozialen Mediums, die durch Retweets das Thema aufwerten. Im Falle von Andy Carvin wurde festgestellt, dass andere Quellen während der ägyptischen Revolution vermerkt worden sind. Carvin zitierte oder bezog sich nicht nur auf prominente und bekannte Akteure sondern auch nicht-prominente Quellen. Durch die mit @ gekennzeichneten Interaktionen wurde zum Einen Transparenz in Form von einer Rückverfolgbarkeit der Quelle geschaffen und zum Anderen der Umgang mit der Quelle und die Art und Weise der Verarbeitung der Informationen im Artikel sichtbar.

Ziel der Studie

Das Forscherteam möchte eine relative große Datenmenge analysieren und dabei sensibel für kontextuelle Nuancen bleiben. Dieses Forschungsziel versuchen sie durch die Verbindung von computergestützten und manuellen Methoden zu realisieren

Methode

Es wurde die Programmiersprache Python genutzt, um ein großes Datenset zu kategorisieren. Mit Spreadsheet und einer Statistik Software wurden die Daten weiter organisiert und strukturiert. Anhand der strukturierten Daten wurde dann die eigentliche Auswahl der für die Forschungsfrage relevanten Daten getroffen. (vgl. Lewis/Zamith/Hermida 2013: 41) Dabei wurde die dynamische und durch Interaktion geprägte, d.h. schnell verändernde Plattform Twitter statisch gemacht, indem die einzelnen Seiten runtergeladen worden sind. Zur Auswertung und Interpretation der Daten wurde eine web-basierte elektronische Kodierungs-Methode entwickelt, um die Arbeit von (menschlichen) Kodierer*innen zu vereinfachen und Fehler zu minimieren. Dabei ist die Forschungsgruppe wie folgt vorgegangen:

1. Daten sammeln:

Twitter ist ein beliebtes Medium für Forscher*innen geworden, da hier ein einfacher Datenzugang gesichert ist. Ein weiterer Vorteil ist, dass die Tweets nach Stichworten oder Hashtags gesammelt werden und relativ schnell sortiert werden können. (vgl. ebd.) In dieser Untersuchung sollten alle Tweets eines User’s gesammelt werden (@acarvin). Zunächst wurden alle Tweets von Andy Carvin mit Hilfe der Programmiersprache Python gesucht. Dabei gab es jedoch massive Probleme, da das Programm immer wieder nach kurzer Zeit aufhörte Tweets zu sammeln, obwohl der Datensatz noch unvollständig war. (vgl. ebd.) Die Forscher stellten fest, dass im Sample immer wieder große Teile fehlten, beispielsweise bestimmte Zeitspannen. Es handelte sich also nicht um willkürliche oder zufällige Fehler, sondern um „Datenstücke“. (vgl. ebd. 42) Diese Lücken zeigen klare Einschränkungen und Limitierungen, die durch die Anwendung algorithmische Methoden entstehen können. Die Folgen eines unvollständigen Datensets können sehr fatal sein und starken Einfluss auf die Validität nehmen, besonders dann wenn die Datensammlung systematische Fehler beinhaltet.

Da der Twitteruser Carvin selbst seine kompletten 60.000 Tweets gesammelt hatte, hatte die Forschungsgruppe das Glück, den vollständigen Datensatz vom User zu bekommen. Diese Möglichkeit haben die meisten Forschungsgruppen natürlich nicht. (vgl. ebd.)

2. Daten gliedern

Für die Gliederung der Daten wurde auf eine computerbasierte Methode zurückgegriffen. Die wichtigsten Daten wurden extrahiert und organisiert, so dass damit eine Inhaltsanalyse möglich wurde. Dabei sind Computerprogramme sehr effizient, um Informationen, basierend auf strukturellen, systematischen Mustern, zu identifizieren und zu kategorisieren. Es wurde die Programmiersprache Python genutzt, um die Datengliederung durchzuführen. (vgl. ebd. 43) Manuell hätte dieser Schritt zu viel Zeit eingenommen. Zudem wäre eine manuelle Datengliederung fehleranfällig.

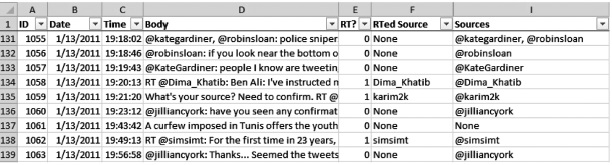

Folgende Komponenten waren wichtig für die Analyse:

a. Datum des Tweets

b. Textkörper

c. Genannte Usernames

d. Tweet oder Retweet

e. Wenn Retweet: original Quelle

Die Unterscheidung zwischen Retweet oder Tweet war sehr wichtig für die Forschungsfrage, da von Interesse war, welche Personen Andy Carvin retweeted. Zuletzt wurden die sortierten Daten in eine Excel Tabelle eingefügt, wo die Daten nach den genannten Komponenten übersichtlich geordnet werden konnten. (vgl. ebd.)

Fig. 1 Screenshot of the Excel Spreadsheet with All Tweets

3. Filter und Interpretation

Im dritten Schritt wurden die gegliederten Daten nach Erscheinungsdatum gefiltert. Von Interesse waren dabei die Tweets zwischen dem 12. und 19. Januar (Tunesische Revolution) und die Tweets zwischen dem 24. Januar und 13. Februar (Ägyptische Revolution). Außerdem wurde zwischen Tweets/Retweets unterschieden. (vgl. ebd. 44)

Daraus resultierten vier Informationssets:

- Tunisia Broadcast und Tunisia Engagement

- Egypt Broadcast und Egypt Engagement

Das endgültige Sample bestand aus 330 einzelnen Quellen. (vgl. ebd. 45) Die im Vergleich zum großen Datensatz relativ geringe Anzahl letztendlich in die Analyse einbezogenen Quellen zeigt, wie wichtig der Prozess der Datenauswahl ist. Eine Herausforderung bei der Arbeit mit Big Data ist es, aus dem riesigen Datensatz, die für die Forschungsfrage relevanten Daten rauszufiltern. Dabei können, wie in dieser Untersuchung gezeigt, computergestützte Methoden zur Datengliederung unerlässlich sein.

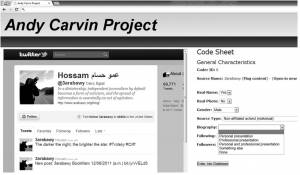

4. Inhaltsanalyse

Da in der Untersuchung der Kontext der Quellen sehr bedeutend für die Forschungsfrage war, schien ein rein computerbasierter Ansatz zur Analyse der Quellen nicht möglich. Die zuletzt folgende Inhaltsanalyse wurde deshalb manuell von Kodierer*innen durchgeführt, die Unterstützung durch eine web-basierte Oberfläche (Interface) mit integrierter Skriptsprache erhielten. Um über die nötige Sensibilität für kontextuelle Nuancen zu verfügen, verwendeten die Kodierer*innen häufig zusätzliche Quellen über die Twitter User, deren Twitterprofile sie codieren und analysieren mussten. Die zu analysierenden Twitter Profilseiten wurden heruntergeladen, da sie sich ständig ändern können. Auf diese Weise konnte gesichert werden, dass alle Kodierer*innen den exakt gleichen Inhalt vorliegen haben. Auch Intercodierung wurde hierdurch möglich. (vgl. ebd. 45-46) Es wurden alle Profilseiten analysiert, die von Andy Carvin retweeted wurden. Die Profilseiten wurden manuell gesammelt. Anschließend wurde mit Hilfe von PHP scripting language und MySQL database codiert. Das elektronische Setup kann Kodierungsfehler reduzieren. Kategorien werden den Kodierer*innen mit Labels angezeigt, die automatisch in einen numerischen Wert konvertiert werden. Das elektronische Kodierungs-Setup wurde für mehrmals durch Intercodierung auf Zuverlässigkeit getestet und anschließend in der Hauptcodierung verwendet. (vgl. ebd. 46)

Fig. 2 Screenshot of the Web Interface for Content Analysis

Fazit

Die hier methodisch vorgestellte Untersuchung zeigt auf, dass computergestütze Methoden neue Wege bieten, um mit großen Datenmengen umzugehen. Es wird deutlich, dass die Möglichkeiten der reinen technischen Methode vor allem bei der Analyse der Daten limitiert bleiben, deshalb plädieren die Forscher für ein Hybrid-Modell, das computergestützte und manuelle Methoden miteinander verbindet. (vgl. ebd. 47) Computergestützte Tools wurden genutzt, um das Sample möglichst objektiv, systematisch und akkurat zu filtern und zu organisieren. Außerdem wird durch sie die Arbeit von menschlichen Kodierer*innen erleichtert. Elektronische Tools waren also ein Mittel, um manuelle Kodierung zu erleichtern und zu optimieren (nicht zu ersetzten). „Hybrid combinations of computational and manual approaches can preserve the strengths of traditional content analysis, with its systematic rigor and contextual awareness, while maximizing the large-scale capacity of Big Data and the efficiencies of computational methods.” (Lewis/Zamith/Hermida 2013: 47)

Die Gefahr von allein computergestützten Methoden ist, dass der Kontext der Daten verloren geht. Eine der großen Herausforderungen bei der Analyse von Big Data, ist es deshalb bei der riesigen Datenmenge den Kontext der einzelnen Quellen nicht aus den Augen zu verlieren. Besonders bei der Arbeit mit riesigen Datenmengen ist das Risiko hoch, dass die große Quantität der Daten mit einem Kontextverlust einhergeht, vor allem dann, wenn die Daten in ein bestimmtes Model passen sollen. „This contextual awareness is doubly important in studies of Big Data, where the sheer volume might encourage researchers to look for aggregate patterns—while missing the subtleties embedded in the production of that digital content.” (ebd. 48)

In dem vorgestellten Hybridansatz wird deutlich, dass es bei der Arbeit mit Big Data nicht ausreicht sich allein auf rechnerischen Methoden zu stützen. Manuelle Forschungsmethoden sollen nicht ersetzt werden, jedoch durch computergestützte Werkzeuge optimiert werden. Ziel soll es sein bestimmte aufwendige Forschungsschritte durch effektive, elektronische Tools zu bewerkstelligen. Bei der Forschung mit Big Data können diese unerlässlich sein, da die Datenmenge ohne sie kaum zu bearbeiten ist. Um den Kontext der Daten nicht zu vernachlässigen sind manuelle Auswertungsmethoden unerlässlich.

Studie 2: Analysefokus

Twitter als Elemete der politischen Diskussion: Themen, Stile, Elemente

Frage der Studie

Beteiligen sich sich Politiker*innen an der Konstruktion von politischer Transparenz und deliberativen Diskursen? Inwieweit beteiligen sie sich?

Methode

In der Studie wurden verschiedene Landtagswahlen in Deutschland drei Wochen vor und eine Woche nach den Wahlenterminen beobachtet. Dabei wurden die vier twitteraktivsten Listenkandidat*innen der Parteien der drei Bundesländer (Sachsen-Anhalt, Rheinland-Pfalz und Baden-Württemberg) ausgesucht. 91.317 Tweets wurden anhand eines RSS-Feed-Agregators gesammelt und nach Absendedatum, Accountname und Akteurszugehörigkeit sortiert und archiviert. Die Twitternachrichten wurden mit Hilfe von QDA Miner inhaltsanalytisch untersucht. (vgl.Thimm et al. 2012: 300ff.)

Aspekte der Analyse

- Verwendungshäufigkeit der Kommunikationsoperatoren

- Aktivitätsprofile und Kommunikationsmuster im Austausch mit anderen Nutzer*innen

- strategisch-funktionale Nutzungsmuster während des Wahlkampfs im Hinblick auf typische Stilmerkmale (vgl. ebd: 300)

Operationsanalyse

In der Operationsanalyse wurde zum einen die Twitteraktivitäten, sowie die Operatorennutzung untersucht. Dabei wurden, aufgrund der Datenmenge, nur die Daten aus Sachsen-Anhalt und Baden-Württemberg zur Untersuchung heran gezogen. Während die Twitteraktivitäten in Baden-Württemberg parteiabhängig variieren, ist zu beobachten, dass in Sachsen-Anhalt die aktive Twitter-Nutzung unabhängig von der Parteizugehörigkeit ist. So nutzten Politiker*innen in Baden-Württemberg die der ‘Piraten-Partei’ und den ‘Grüne’ angehören, Twitter am aktivsten. Die Operatorennutzung der fünf aktivsten Politiker*innen wurde hinsichtlich ihrem Kommunikationsverhalten analysiert. Dabei wurde die Anzahl der Retweets, @-Operatoren, Hashtags und Hyperlinks gezählt. Durch die Häufigkeit der benutzen Operatoren wurde auf ein bestimmtes Nutzerverhalten verwiesen. So wurde die Twitternutzung von Jens Bullerjahn (SPD) als thematisch-informativ eingestuft, da dieser in 50% seiner gesendeten Tweets Hyperlinks verwendet. Im Vergleich dazu wurde das Nutzungsverhalten von Michael Vorsprach als interaktiv-persönlich aufgefasst, da er in 42% seiner Tweets den @-Operator benutze. Jede*r Politiker*in hat demnach einen eigenen Kommunikationsstil, bzw. eine Vernetzungsstrategie, welche durch die Verwendung der vier Operatoren bestimmt wird.

Wahlkampfstrategien

Die Tweets der einzelnen Politiker*innen geben nicht nur Aufschluss über ihr Verhalten mit anderen Nutzer*innen, sondern auch über die Art und Weise, wie sie Wahlkampf betreiben. So wurden in der Studie vier Strategien identifiziert:

- Veranstaltungswerbung

- politische Parolen/Wahlkampfslogans

- Kritik/Negativbewertung der politischen Gegner*innen

- interne Kommunikationsmittel (vgl. ebd: 304-306)

Bürger-Dialog

Schließlich stellt die Studie fest, dass die Politiker*innen auf Twitter vor allem mit anderen Politiker*innen in Interaktion treten (68,40%). Nur 24,40% der Interaktionen von Politker*innen wurden mit Bürger*innen geführt. Dies führte zur Annahme, dass ein Mangel an direkter Kommunikation fehle und der Austausch eher von Bürger*innen initiiert wurde. (vgl. ebd: 309)

Twitter als Wahlkampfmedium

„Die mediale Durchdringung des Lebensalltags gilt als zentrales Moment des aktuellen gesell-schaftlichen Wandels.“ (Thimm/Einspänner/Dang-Anh 2012: 294) Besonders neue mediengestützte Kommunikationsformen beeinflussen soziokulturelle Faktoren in der Gesellschaft. Für die im Folgenden vorgestellte Studie ist vor allem die politische Perspektive der Mediatisierung von Interesse. Das Konzept der Mediatisierung des Politischen geht davon aus, dass sich die politischen Kommunikationsformen durch technische Entwicklungen strukturell verändern. Dabei ist die spezifische Informations- und Nutzungslogik der Sozialen Medien ein entscheidender Faktor für den Strukturwandel der Öffentlichkeit. Das bedeutet Öffentlichkeit wird nicht mehr allein von etablierten, professionellen Medienschaffenden, sondern mehr von einzelnen Individuen gestaltet und somit zu einem gemeinsamem politischer (Ver)Handlungsraum. Dabei wird das Internet auch immer wichtiger für Meinungs- und Willensbildungsprozesse. (vgl. ebd.)

Besonders die Bedeutung von Twitter nimmt für die Öffentlichkeitsarbeit von Politiker*innen eine immer wichtigere Rolle ein. Ein Diskurs zwischen Bürger*innen und Politiker*innen kann zum Beispiel durch von Politiker*innen online gestellten Beiträgen entstehen. Dabei lassen sich die personalisierte und die inhaltliche Komponente bei politischer Kommunikation in Sozialen Netzwerken kaum voneinander trennen. (vgl. ebd. 297)

Studie über die Nutzung des Twitterdiensts von Politiker*innen während der Landtagswahlkämpfe auf partizipationsermöglichende Elemente

Twitter im Diskurs

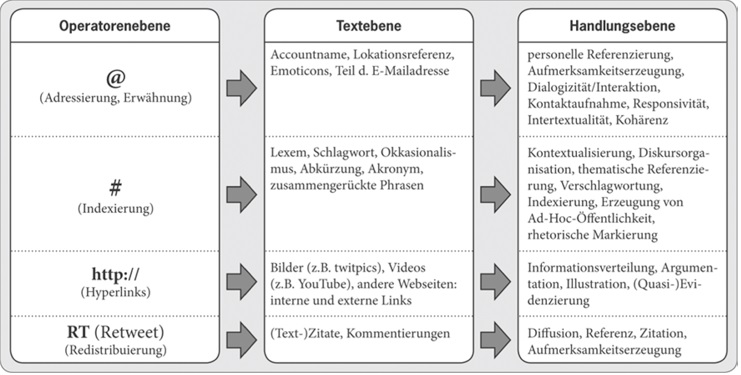

Twitterbeiträge sind häufig Teil eines thematischen Diskurses innerhalb der Twittersphäre. (vgl. ebd. 298) An Diskursen können eine Handvoll, aber auch millionen von Nutzer*innen beteiligt sein. Twitter kann als ein Diskurssystem bezeichnet werden. Es handelt sich „um ein komplexes Bezugnahmesystem zwischen Personen und den von ihnen publizierten Inhalten“ (ebd.). Die Twitterkommunikation wird in dieser Studie auf drei Ebenen analysiert:

Operatorenebene: durch programmdefinierte Zeichencodes bestimmt

Textebene: mit Operatoren verknüpfte Inhalte

Handlungsebene: semantische Bezüge zwischen den verwendeten Operatoren, dem Kontext des Tweets und ihren Benutzern.

Fig. 3 Ebenen der Twitterkommunikation: Funktionales Operatorenmodell des Diskursuniversums Twitter

Mithilfe der Operatoren (@, # , RT, Link) können User spezifische, operatorendeterminierte Handlungen vollziehen.

@ Verlinkung zu Adressierten oder Erwähnungen von Personen. Generiert Kohärenz. Durch Kontaktaufnahme kann Diskussion angestoßen werden.

# inhaltliche Kontextualisierung, thematische Verschlagwortung, inhaltliche Funktion. Twitterbeiträge zu einem Thema sind hierdurch leichter zu finden.

Link Argumentation, Illustration, Verweis auf Wissenbestände im Netz, um so User zu informieren oder um die eigene Meinungen und Argumentationen mit Belegen zu unterstützen.

RT Zitation oder Weiterleitung.

Die genannten Operatoren konstituieren das Diskursnetzwerk Twitter. Durch sie zeichnet sich das Netzwerk auf inhaltlicher Ebene als eine Mischung aus Nachrichten, synchroner interpersonaler Kommunikation und sozialer Gruppenbildung aus. (vgl. ebd. 300) Das besondere an diesem Netzwerk ist der kommunikative, informative Austausch, bei dem die Rezeption und die Produktion von Inhalten direkt miteinander verbunden sind. Somit fühlen sich Nutzer*innen zur Beteiligung und Kritik ermächtigt. Dies führt dazu, dass die Kontrolle über Öffentlichkeitsprozesse nicht mehr allein in der Hand von Medienkonzernen liegt, sondern auch in der Hand einzelner Aktivist*innen, wie zum Beispiel bei Andy Carvin während des Arabischen Frühlings. (vgl. ebd.)

Quellen

Donges, P. (2008). Medialisierung politischer Organisationen. Parteien in der Mediengesellschaft. Wiesbaden: VS Verlag für S ozialwissenschaften.

Lewis, Seth C./Rodrigo Zamith/Alfred Hermida 2013. Content Analysis in an Era of Big Data: A Hybrid Approach to Computational and Manual Methods: 34-52.

Thimm, Caja/Jessica Einspänner/Mark Dang-Anh 2012. Twitter als Wahlkampfmedium. Modellierung und Analyse politischer Social-Media-Nutzung: 293-313.

Thimm, C., Einspänner, J., & Dang-Anh, M. (2012). Politische Deliberation online – T witter als Element des politischen Diskurses. In A. Hepp & F . Krotz (Hrsg.), Mediatisierte Welten: Forschungsfelder und